چرا رایانه های مدرن برای مطابقت با تاخیر ورودی یک Apple IIe

چرا رایانه های مدرن برای مطابقت با تاخیر ورودی یک Apple IIe

توسط جوئل هروسکا

مقایسه تأخیر ورودی یک رایانه مدرن با سیستمی که 30-40 سال سن دارد در ظاهر مضحک به نظر می رسد. حتی اگر رایانه روی میز یا نوار شما چندان جدید یا سریع نباشد ، با این حال هزار یا بیشتر سریعتر از فناوری پیشرفته دهه 1980 با چندین هسته CPU ، تخصصی ...

شما می توانید این کامپیوتر فوق العاده تمشک پای سبک یکپارچهسازی با سیستمعامل

شما می توانید این کامپیوتر فوق العاده تمشک پای سبک یکپارچهسازی با سیستمعامل

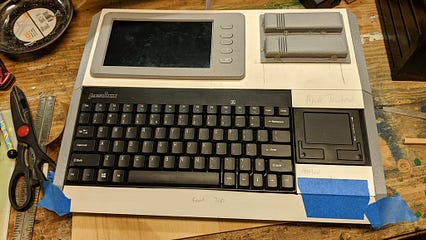

قبل از جعبه های سیاه عمومی 00s و جعبه های بژ عمومی 90s ، تولید کنندگان رایانه در واقع سعی کردند ماشین هایی بسازند که ظاهر منحصر به فردی دارند به برخی از آنها ، مانند ZX Spectrum و Commodore 64 ، اکنون به دلیل طرح های شیک بسیار ارزشمند هستند. اما اگر می خواهید یک رایانه مدرن داشته باشید ، تنها انتخاب واقعی شما این است که رومیزی خود را بسازید یا یک لپ تاپ شبیه به یک تخته آلومینیوم خریداری کنید. خوشبختانه ، یک گزینه دیگر نیز وجود دارد و آن این است که برای ساختن رایانه رزبری پای خود به سبک یکپارچهسازی با سیستم ، آموزش Lewisb42 را دنبال کنید.

طراحی رایانه FLIPT-BIT lewisb42 از رایانه ای ساخته شده است که سونی در سال 1984 به نام HIT-BIT HB-101 ساخته است. مانند بسیاری از رایانه های دیگر در دهه 80 ، HB-101 دارای صفحه کلید داخلی و حتی جوی استیک بود. FLIPT-BIT از همان مفهوم پیروی می کند ، اما جوی استیک را با یک صفحه لمسی کوچک عوض می کند و یک صفحه نمایش TFT 7 اینچی اضافه می کند. lewisb42 برای ساخت خود از Raspberry Pi 3 Model B+ استفاده کرد ، اما شما باید بتوانید از تمشک تمام اندازه استفاده کنید مدل Pi ، از جمله Raspberry Pi 4 Model B.

برای ساختن FLIPT-BIT خود ، به صفحه نمایش رزبری پای 7 اینچی ، منبع تغذیه 12 ولت 5 آمپر ، تنظیم کننده ولتاژ 12 ولت تا 5 ولت و صفحه کلید USB و صفحه ترکیبی فشرده (هر دو از Perixx) نیاز دارید. محفظه از ترکیبی از قطعات چاپ سه بعدی ، ورق اکریلیک و ورق PVC فوم ساخته شده است. بعد از اینکه همه اجزای خود را با هم جمع کردید و محفظه به پایان رسید ، مونتاژ نهایی به سادگی اتصال همه کابل ها ساده است. فضای زیادی در داخل کیس وجود دارد ، بنابراین نباید در مرتب کردن همه چیز مشکلی داشته باشید. نتیجه یک کامپیوتر مدرن است که به نظر می رسد مانند نسخه های کلاسیک دهه 80!

مس ، برنز ، تنگستن: ردیابی پیشرفت سریع کامپیوتر در اینترنت

مس ، برنز ، تنگستن: ردیابی پیشرفت سریع کامپیوتر در اینترنت

انتشار تنگستن سومین مرحله از پنج نقطه عطفی است که با راه اندازی کامل رایانه اینترنتی در اواخر سال 2020 به اوج خود می رسد.

< img src = "https://cdn-images-1.medium.com/max/426/1*F6x6IUb6NhCkSqY311k8-A.jpeg">"رایانه اینترنتی به شدت به قدرت رمزنگاری متمایل است ، معرفی طرح های جدید که باعث شگفتی و حیرت شما خواهد شد. این قدرت WebAssembly را آزاد می کند. اینترنت را دوباره تصور می کند و ماهیت نرم افزار را دوباره تصور می کند. بنیاد DFINITY با تمرکز کامل در حال گسترش و ساخت رایانه اینترنتی به صورت مخفیانه است. DFINITY همیشه وسواس جنبه های بیرونی آنچه ممکن است داشت. تنگستن انتشار جزئیات مربوط به معماری و علم فنی رایانه اینترنتی و کد نرم افزاری آن را آغاز می کند. " - دومینیک ویلیامز ، بنیانگذار و دانشمند ارشد DFINITY

سه سال تحقیق و توسعه متمرکز منجر به پیشرفت مداوم برنامه انتشار عمومی رایانه اینترنتی شده است ، و الگویی جدید برای توسعه نرم افزار است. برای درک کامل دامنه این کار ، کمک می کند تا هر یک از این نسخه ها به عنوان اقدامی برای بازسازی دوره های قبلی محاسبات به شکل غیرمتمرکز در نظر گرفته شود.

این مجموعه با انتشار مس (بر اساس ترمینال) در نوامبر 2019 ، پس از انتشار برنز (وب دسکتاپ) در ژانویه گذشته ، و در حال حاضر در نسخه Tungsten (توسعه برنامه تلفن همراه) این ماه وارد می شود و رایانه اینترنتی را برای اولین بار برای توسعه دهندگان شخص ثالث باز می کند.

< bq> بیشتر بخوانید: رایانه اینترنتی از توسعه دهندگان شخص ثالث در تنگستن استقبال می کندتنگستن (معروف به "شبکه توسعه دهندگان") سومین مرحله از پنج مرحله انتشار است که در نهایت رایانه اینترنتی در نهایت به عنوان یک برنامه افزودنی به اوج خود می رسد. اینترنت عمومی در اواخر امسال در اینجا نگاهی داریم به اینکه چگونه به این نقطه رسیدیم… تعداد فزاینده ای از علاقه مندان به رایانه اینترنتی از آن زمان برای ساختن سیستم ها و خدمات قابل توجهی که بر روی رایانه اینترنتی اجرا می شود استفاده می کنند.

انتشار مس همچنین معرفی رسمی زبان Motoko را نشان می دهد. برخی از توسعه دهندگان تعجب می کردند که چرا یک زبان برنامه نویسی کاملاً جدید ضروری است. پاسخ کوتاه این است که Motoko-که توسط یک تیم DFINITY به رهبری Andreas Rossberg (همکار خالق WebAssembly) ایجاد شده است-زبانی است که برای ایجاد نرم افزارهای ضد دستکاری و باز کردن خدمات اینترنتی برای رایانه اینترنتی با استفاده از WebAssembly (Wasm) بهینه شده است.

Motoko یک زبان مدرن است که برای توسعه دهندگانی که آشنایی اولیه با JavaScript ، Rust ، Swift ، TypeScript دارند طراحی شده است. ، C#، یا Java. (نسخه باز LinkedIn) که روی رایانه اینترنتی اجرا می شود.

دومینیک ویلیامز در انتشار برنز در مجمع جهانی اقتصاد در داووس در ژانویه 2020.

دومینیک ویلیامز در انتشار برنز در مجمع جهانی اقتصاد در داووس در ژانویه 2020. به جای یک گره روی یک لپ تاپ ، برنز دارای یک شبکه ای از سرورها در یک مرکز داده مستقل در سوئیس با اجماع کامل و لایه های P2P/transport. به جای برنامه های ترمینال ، قوطی های ساخته شده با Bronze قسمت جلویی خود را ذخیره می کنند ، به این معنی که برنامه ها می توانند وضعیت خود را ذخیره کنندمنطقی ، و جلویی مستقیماً در یک قوطی. و به جای قوطی هایی که فقط از پایانه می توان آنها را فراخوانی کرد ، قوطی های برنز می توانند پیام هایی را برای یکدیگر ارسال کنند و الگوهای پیام رسانی بین قوطی را در اختیار توسعه دهندگان قرار دهند.

LinkedUp: پشت صحنه

LinkedUp: front-end

TUNGSTEN

تنگستن ، سومین نقطه عطف ، حتی مهمتر است قدم به جلو رایانه اینترنتی در حال حاضر در چندین مرکز داده در سراسر جهان اجرا می شود و به توسعه دهندگان و تیم های شخص ثالثی که با استفاده از طیف گسترده ای از ابزارهای توسعه دهنده شبکه در حال ساخت برنامه های کاربردی و سیستم های سازمانی هستند ، باز می شود.

برای انتشار تنگستن ، DFINITY CanCan را نشان می دهد ، یک جایگزین باز برای TikTok که نیست متعلق به یک شرکت دولتی یا دولتی است یا اداره می شود. CanCan با کمتر از 1000 خط کد ساخته شده است تا سادگی ساخت در رایانه اینترنتی را به نمایش بگذارد. (برای مثالهای بیشتری که نشان می دهد توسعه دهندگان چگونه می توانند برنامه ها را در رایانه اینترنتی بنویسند و به کار گیرند ، نتایج 48 ساعته داخلی Tungsten Hackathon را بررسی کنید.)

تنگستن به کامپیوتر اینترنت اجازه می دهد از وب دسکتاپ پرش کند. برنامه توسعه تلفن همراه ، و مفروضات رایج در مورد کامپیوترهای بلاک چین را به چالش می کشد.

برای دسترسی به شبکه توسعه دهندگان تنگستن رایانه اینترنتی در dfinity.org/tungsten درخواست دهید .

به توسعه دهندگان ما بپیوندید و شروع به ساختن در forum.dfinity.org کنید.

بینایی رایانه ای

بینایی رایانه ای

آیا ترانسفورماتورها جایگزین CNN ها در بینایی رایانه ای می شوند؟

در کمتر از 5 دقیقه ، می دانید که چگونه می توان معماری ترانسفورماتور را با یک مقاله جدید در بینایی رایانه به کار برد. به نام Swin Transformer

تصویر نویسنده.

تصویر نویسنده. این مقاله به احتمال زیاد نسل بعدی شبکه های عصبی برای همه برنامه های بینایی رایانه است: معماری ترانسفورماتور. مطمئناً قبلاً در مورد این معماری در زمینه پردازش زبان طبیعی یا NLP ، عمدتا با GPT3 که در سال 2020 سر و صدای زیادی ایجاد کرده است ، شنیده اید. ترانسفورماتورها را می توان به عنوان ستون فقرات عمومی برای بسیاری از برنامه های مختلف و نه تنها NLP استفاده کرد. به در عرض چند دقیقه ، می دانید که چگونه می توان معماری ترانسفورماتور را با یک مقاله جدید به نام Swin Transformer توسط Ze Lio و همکاران در بینایی رایانه اعمال کرد. از Microsoft Research [1].

این مقاله ممکن است کمتر از حالت معمول درخشان باشد زیرا نتایج واقعی یک برنامه دقیق را نشان نمی دهد. در عوض ، محققان [1] نشان دادند که چگونه می توان معماری ترانسفورماتورها را از ورودی های متن به تصاویر تطبیق داد و از شبکه های عصبی پیچیده ای از بینایی رایانه پیشی گرفت ، که به نظر من از بهبود کمی جزئی بسیار هیجان انگیز است. و البته ، آنها کد [2] را برای شما ارائه می دهند تا خودتان پیاده سازی کنید! پیوند در منابع زیر است.

چرا از ترانسفورماتورها در شبکه های CNN استفاده کنیم؟

اما چرا ما سعی می کنیم شبکه های عصبی متحرک (CNN) را برای برنامه های بینایی رایانه جایگزین کنیم؟ این به این دلیل است که ترانسفورماتورها می توانند از حافظه بسیار بیشتری استفاده کنند و در مورد کارهای پیچیده بسیار قوی تر هستند. این البته با توجه به این واقعیت است که شما داده هایی برای آموزش آن دارید. ترانسفورماتورها همچنین از مکانیزم توجه معرفی شده در مقاله 2017 استفاده می کنند توجه فقط به آن نیاز دارید [3]. توجه به معماری ترانسفورماتور اجازه می دهد تا به صورت موازی محاسبه شود.

فرآیند توجه در NLP تصویر توسط Davide Coccomini با اجازه بازنشر می شود. شبکه های CNN بسیار محلی تر هستند و از فیلترهای کوچک برای فشرده سازی اطلاعات به سمت پاسخ کلی استفاده می کنند.

در حالی که این معماری برای کارهای طبقه بندی عمومی قدرتمند است ، اما اطلاعات مکانی لازم برای بسیاری از وظایف مانند تشخیص نمونه را ندارد. این به این دلیل است که پیچیدگی ها روابط پیکسل های فاصله دار را در نظر نمی گیرند.

فرآیند توجه در NLP تصویر توسط Davide Coccomini با اجازه بازنشر می شود. شبکه های CNN بسیار محلی تر هستند و از فیلترهای کوچک برای فشرده سازی اطلاعات به سمت پاسخ کلی استفاده می کنند.

در حالی که این معماری برای کارهای طبقه بندی عمومی قدرتمند است ، اما اطلاعات مکانی لازم برای بسیاری از وظایف مانند تشخیص نمونه را ندارد. این به این دلیل است که پیچیدگی ها روابط پیکسل های فاصله دار را در نظر نمی گیرند.

مثال توجه به خود در Transformers برای NLP (چپ) و دید رایانه (راست). تصویر توسط نویسنده. برای معرفی سریع مفهوم توجه ، بیایید یک مثال ساده NLP را ارسال کنیم که یک جمله را برای ترجمه آن به یک شبکه ترانسفورماتور ارسال می کند. در این مورد ، توجه اساساً اندازه گیری نحوه ارتباط هر کلمه در جمله ورودی با هر کلمه در جمله ترجمه خروجی است. به طور مشابه ، چیزی وجود دارد که ما آن را توجه به خود می نامیم و می تواند به عنوان اندازه گیری تأثیر یک کلمه خاص بر همه کلمات دیگر یک جمله تلقی شود. این فرایند مشابه را می توان برای تصاویر محاسبه کننده توجه اعمال کردتکه های تصاویر و روابط آنها با یکدیگر ، همانطور که در مقاله بیشتر بحث خواهیم کرد.

مثال توجه به خود در Transformers برای NLP (چپ) و دید رایانه (راست). تصویر توسط نویسنده. برای معرفی سریع مفهوم توجه ، بیایید یک مثال ساده NLP را ارسال کنیم که یک جمله را برای ترجمه آن به یک شبکه ترانسفورماتور ارسال می کند. در این مورد ، توجه اساساً اندازه گیری نحوه ارتباط هر کلمه در جمله ورودی با هر کلمه در جمله ترجمه خروجی است. به طور مشابه ، چیزی وجود دارد که ما آن را توجه به خود می نامیم و می تواند به عنوان اندازه گیری تأثیر یک کلمه خاص بر همه کلمات دیگر یک جمله تلقی شود. این فرایند مشابه را می توان برای تصاویر محاسبه کننده توجه اعمال کردتکه های تصاویر و روابط آنها با یکدیگر ، همانطور که در مقاله بیشتر بحث خواهیم کرد.

ترانسفورماتورها در بینایی کامپیوتر

اکنون که می دانیم ترانسفورماتورها بسیار جالب هستند ، هنوز مشکلی در برنامه های بینایی رایانه وجود دارد. در واقع ، درست مانند ضرب المثل رایج "یک تصویر هزار کلمه ارزش دارد" ، تصاویر حاوی اطلاعات بسیار بیشتری نسبت به جملات هستند ، بنابراین ما باید معماری ترانسفورماتور اصلی را برای پردازش م imagesثر تصاویر تطبیق دهیم. این مقاله در مورد این است.

پیچیدگی ترانسفورماتورهای بینایی. تصویر توسط داوید کوکومینی با مجوز بازنشر می شود. بنابراین زمان محاسبه و نیازهای حافظه افزایش می یابد. در عوض ، محققان این پیچیدگی محاسباتی درجه دوم را با پیچیدگی محاسباتی خطی به اندازه تصویر جایگزین کردند.

پیچیدگی ترانسفورماتورهای بینایی. تصویر توسط داوید کوکومینی با مجوز بازنشر می شود. بنابراین زمان محاسبه و نیازهای حافظه افزایش می یابد. در عوض ، محققان این پیچیدگی محاسباتی درجه دوم را با پیچیدگی محاسباتی خطی به اندازه تصویر جایگزین کردند.  اولین مرحله از معماری Swin Transformer ، نشانه گذاری تصویر. تصویر نویسنده.

اولین مرحله از معماری Swin Transformer ، نشانه گذاری تصویر. تصویر نویسنده. ترانسفورماتور Swin [1] [2]

روند دستیابی به این امر بسیار ساده است. در ابتدا ، مانند اکثر کارهای بینایی رایانه ، یک تصویر RGB به شبکه ارسال می شود. این تصویر به وصله تقسیم می شود و هر پچ به عنوان یک نشانه تلقی می شود. و ویژگی های این توکن ها مقادیر RGB خود پیکسل ها هستند. برای مقایسه با NLP ، می توانید این را به عنوان تصویر کلی جمله ببینید ، و هر پچ کلمات آن جمله است. توجه به خود بر روی هر پچ اعمال می شود ، که در اینجا به آن پنجره می گویند. سپس ، پنجره ها جابجا می شوند و در نتیجه پیکربندی پنجره جدیدی برای اعمال مجدد توجه به خود ایجاد می شود. این امکان ایجاد ارتباط بین پنجره ها را با حفظ بازده محاسبه این معماری پنجره دار فراهم می کند. این امر در مقایسه با شبکه های عصبی پیچشی بسیار جالب است زیرا اجازه می دهد روابط پیکسل های دوربرد ظاهر شود.

توجه به خود در پنجره ها اعمال می شود. تصویر نویسنده.

توجه به خود در پنجره ها اعمال می شود. تصویر نویسنده. این فقط برای مرحله اول بود. مرحله دوم بسیار مشابه است اما ویژگی های هر گروه دو نفره را با دو تکه مجاور به هم پیوند می دهد و وضوح تصویر را تا دو برابر کاهش می دهد. این روش در مراحل 3 و 4 دو بار تکرار می شود و همان وضوح نقشه ویژگی را ایجاد می کند ، مانند شبکه های معمولی کانولوشن مانند ResNets و VGG. محصولات خوب ، بله و خیر. تصویر نویسنده.

قدرت پیچیدگی در این است که فیلترها از وزن های ثابت در سطح جهانی استفاده می کنند و ویژگی ترجمه-تغییر ناپذیری پیچیدگی را امکان پذیر می کند و آن را به یک تعمیم قدرتمند تبدیل می کند. در توجه به خود ، وزن ها در سطح جهانی ثابت نیستند. در عوض ، آنها بر خود زمینه محلی تکیه می کنند. بنابراین ، توجه به خود هر پیکسل را در نظر می گیرد ، بلکه رابطه آن را با پیکسل های دیگر در نظر می گیرد.

تغییر پنجره مشکل رابطه طولانی مدت. تصویر توسط نویسنده.

تغییر پنجره مشکل رابطه طولانی مدت. تصویر توسط نویسنده. همچنین ، تکنیک پنجره تغییر یافته آنها امکان نمایش پیکسل های دوربرد را فراهم می کند. متأسفانه ، این روابط طولانی مدت تنها با پنجره های مجاور ظاهر می شود. بنابراین ، از دست دادن روابط بسیار دور ، نشان می دهد که هنوز جایی برای بهبود معماری ترانسفورماتور در مورد بینایی رایانه وجود دارد.

نتیجه گیری

همانطور که در مقاله بیان شده است. :

و من کاملاً موافقم. من فکر می کنم استفاده از معماری مشابه برای بینایی NLP و رایانه می تواند روند تحقیق را به میزان قابل توجهی تسریع کند. البته ، ترانسفورماتورها هنوز به شدت وابسته به داده هستند و هیچ کس نمی تواند بگوید آیا آینده NLP یا دید رایانه ای خواهد بود یا خیر. با این حال ، بدون شک این یک گام مهم برای هر دو زمینه است!

امیدوارم این مقاله بتواند شما را با ترانسفورماتورها و نحوه کاربرد آنها در برنامه های بینایی رایانه آشنا کند.

ممنون که خواندید! مقالات بیشتری مانند این را در وبلاگ من بیابید و آنها را قبل از به اشتراک گذاری در Medium بخوانید!

اگر از کارهای من خوشتان می آید و می خواهید با هوش مصنوعی به روز باشید ، قطعاً باید مرا در وب سایت من دنبال کنید سایر حسابهای رسانه های اجتماعی (LinkedIn ، Twitter) و مشترک خبرنامه هوش مصنوعی هفتگی من شوید!

برای حمایت از من:

مراجع

[1] Liu ، Z. et al.، 2021، "Swin Transformer: Hierarchical Vision Transformer using Shifted Windows" ، arXiv preprint https : //arxiv.org/abs/2103.14030v1

[2] Swin Transformer ، Lio ، Z. et al ، کد GitHub ، https://github.com/microsoft/Swin-Transformer

[3] واسوانی ، A. و همکاران ، 2017. "توجه تنها چیزی است که شما نیاز دارید" ، پیش چاپ arXiv https://arxiv.org/a bs/1706.03762.